EUVAS: Warum der allgemeine Rechtsrahmen zu Algorithmen rechtsdogmatisch die Grundpfeiler unserer Demokratie gefährdet

Die Dogmatik des Datenschutzes ist individualrechtlich. Das „Recht auf Privatleben“ und das „Recht auf informationelle Selbstbestimmung“ stehen im Mittelpunkt. Die Datenethikkommission (DEK) will diesen Ansatz fortschreiben, indem sie ein „Recht auf digitale Selbstbestimmung“ erfindet. Dies führt am Ende dazu, dass sie den Wald vor lauter Bäumen nicht mehr sieht. Auf welche gesellschaftlich-ethischen und rechtlichen Grundsätze sich die DEK stützt, ist insbesondere im Hinblick auf die Gemeinwohlorientierung unklar. Aus der Summe individualrechtlicher Ansprüche allein lassen sich Werte des Gemeinwohls jedenfalls nicht ableiten.

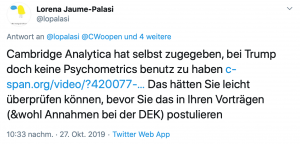

Die DEK stützt sich darüber hinaus auf empirisch nicht bestätigte Hypothesen und folgt daher eher dem Narrativ politischer Fiktionen als wissenschaftlichen Erkenntnissen. Dies gilt etwa für die vermeintliche Manipulation der US-Wahlen 2016 durch die Nutzung eines Ansatzes, den Cambridge Analytica „Psychometrics“ nannte.

Link:Â https://twitter.com/lopalasi/status/1188569483293741058

Die DEK gibt eine ganze Reihe von rechtlichen Empfehlungen ab, ohne zuvor den Regelungsbedarf und die ethischen Grundsätze, Regeln und Begründungen ermittelt zu haben. In Teil I dieses Blogbeitrags wurde bereits erläutert, dass die DEK die Natur und Effekte algorithmischer Systeme verkennt und warum die vorgeschlagenen Regelungsansätze aufgrund ihrer ethischen Inhaltsleere methodologisch nicht angemessen sind. Im Folgenden wird aufgezeigt, welche verheerenden Folgen sich rechtsdogmatisch ergeben, wenn Regelungen eher technik- als ethikgetrieben sind.

1. Technikbasierte Prinzipien und die Gefahr der WillkĂĽr

Die Aufgabe der Ethik ist es, Prinzipien und Verfahren fĂĽr die Frage zu empfehlen, wie sich der Mensch in bestimmten Situationen verhalten soll. Aus diesem Grunde ist die Argumentation der DEK inkonsistent. Einerseits vertritt sie richtigerweise (!), dass es nur und immer Menschen sind, die entscheiden und gegebenenfalls auch diskriminieren – auch wenn sie dies mit Hilfe von Technologien machen. Andererseits fordert sie allgemeine technische Prinzipien fĂĽr Algorithmen in Form einer Verordnung (EUVAS), als könnte die technische Regulierung von Algorithmen doch auf einmal die Regulierung menschlichen Verhaltens ersetzen.

Kritikwürdiges Kritikalitätsmodell

Das Fehlen ethischer Grundsätze macht die aufgestellten technische Forderungen wirkungslos.

a) Fehlender Kontext

Im Gegensatz zu ethischen Prinzipien lassen sich technische Prinzipien nicht über alle Kontexte hinweg integrieren. Das zeigt sich eindrücklich bei dem vorgeschlagenen Kritikalitätsmodell: das zweidimensionale Pyramidenmodell besteht aus fünf Risikostufen. Auf der höchsten Stufe soll die Technologie sogar verboten werden. Das Format bildet aber nicht die Komplexität der Governance algorithmischer Systeme ab. Ohne ethische Bewertungsmaßstäbe sagt dieses Modell letztlich nichts aus:

- Art der Risiken:Â Die Risiken fĂĽr das Individuum sind oft nicht deckungsgleich mit den Risiken fĂĽr die Gesellschaft.

- Nicht nur zwei Dimensionen: Die notwendigen Abwägungen und verschiedenen Risiken kann man in solch einer zweidimensionalen Matrix nicht abbilden.

- Optimierbarkeit: Darüber hinaus können algorithmische Systeme nur im Hinblick auf einen bestimmten Wert optimieren. Die Forschung von Krishna Gummadi hat gezeigt, dass es keinen Algorithmus gibt, der verschiedenen Gerechtigkeitsvorstellungen und Logiken genügen kann.

b) Massive Ausweitung auf nicht-algorithmische Aspekte

Governance sollte vielmehr die gesamten Policy-Maßnahmen für eine bestimmte Tätigkeit in Betracht ziehen, in den das algorithmische System eingebettet ist. Diese sind aber nicht algorithmischer Natur. Anstelle einer holistischen Betrachtung, würde der von der DEK vorgeschlagene technische grundsatzlose Ansatz entweder nur einen Teilaspekt beleuchten -und wäre somit wirkungslos. Oder er würde sich massiv auf nicht-technische Prozesse ausweiten. Durch die Hintertür würde das Modell den bisher geltenden Regeln und Gesetzen für alle möglichen wirtschaftlichen, kommunikativen, administrativen (etc., etc.) Vorgänge eine neue Logik auferlegen.

c) Ethische Scheuklappen

Darüber hinaus lenkt der Kritikalitätsansatz von der Frage nach den tatsächlichen ethischen Werten ab, die als Kriterien für eine Prüfung gelten sollen. Durch eine simplifizierte Darstellung der Dimensionen von Risiken drohen Scheuklappen für eine gesamtethische Betrachtung. Durch die vorgelegte Matrix wird eine unsystematische, reduzierte Betrachtung legitimiert, die Tür und Tor für Missbrauch durch die Modellanwender öffnet.

Es bleiben auf ethischer Ebene jede Menge offener Fragen, die aber beantwortet werden mĂĽssten, bevor solch ein Modell dem Normgeber empfohlen werden kann:

- RechtsgĂĽter:Â Welches sind die individuellen und welches die kollektiven RechtsgĂĽter, die zu schĂĽtzen sind?

- Allgemeine Risiken: Gibt es allgemeine Risiken, die quer über alle Sektoren in der Gesellschaft abstrahiert werden können? Welche wären diese?

- Skalierung: Wie können ethische Prinzipien in einer Skala von 1 bis 5 quantifiziert werden?

- Methodik:Â Welche Grenzen gibt es zu dieser Methode?

- Anwendung: Wie können verschiedene Prinzipien in der Pyramide nebeneinander quantifiziert und bewertet werden?

- Zielkonflikte: Welche Prinzipien werden auf Kosten von welchen anderen Prinzipen eingeschränkt?

Transparenz ist kein Ersatz fĂĽr KontrollmaĂźnahmen

Aus ethischer Sicht ist das konstante Fordern nach Transparenz für Aufsichtsbehörden zwar ein notwendiger Schritt, verlangt gleichzeitig jedoch eine Definition von Transparenz: die Logik des Systems allein verrät noch nichts über die politischen Effekte des Systems.

Ein Scoring Modell sagt wenig ĂĽber den Policy-Kontext, in dem das Modell genutzt wird:

- Ab welchen Grenzwerten werden welche Konditionen angeboten?

- Wird Menschen mit sehr schlechten Scores ein Kredit verweigert?

- Oder bekommen sie vielmehr einen Kredit mit schlechten Konditionen, sodass die Enteignungsfälle in die Höhe getrieben werden?

Zudem bleiben die weiteren Maßnahmen und Schritte, mit denen die Aufsicht eine effiziente Kontrolle vollziehen soll, unklar. Transparenz ist kein Prinzip, es ist ein Mittel, um die Erfüllung eines bestimmten Prinzips oder Verfahrens zu kontrollieren. Die sozialen Effekte algorithmischer Systeme können nicht allein durch Transparenz kontrolliert werden. Hierfür bedarf es weiterer Maßnahmen.

In dem Bericht der DEK ist Transparenz ein reiner Ersatz für die Entwicklung angemessener Governance- und Aufsichtsstrukturen und Verfahren. Mit Transparenz wird am Ende Verantwortung dorthin transferiert, wo die Informationen nicht verstanden werden und wo sie auch nicht hingehören: beim Individuum oder beim Verbraucher. Eine Teilverantwortung durch Transparenz auf Informationsempfänger zu transferieren, ist aber nur legitim, wenn die Informationsempfänger tatsächlich die komplexe Information zu verstehen.

2. Gesetz als Architektur: das Fällen von rechtlichen Trägerwänden aus dekorativen Zwecken.

Durch Instrumente wie das Kritikalitäts-Modell oder allgemeine Anforderungen an Algorithmen, die im Vorschlag einer „EU-Verordnung zu Algorithmischen Systemen“ (EUVAS) gipfeln, werden algorithmischen Formeln kontextlos technische Anforderungen und Regelungstechniken ĂĽbergestĂĽlpt. Dies soll sich darĂĽber hinaus auf die gesamte Governance der Systeme auswirken – somit auch auf das, was nichts mit der Technik zu tun hat und ganz sicher nicht mit technikorientierten Ansätzen geregelt werden kann.

Überformung aller Rechtsdisziplinen. Oder der Abriß rechtlicher Trägerwände aus dekorativen Gründen

Im Grunde würde dem manuellen oder maschinellen Handeln von Menschen, die algorithmische Systeme nutzen, durch den risikobasierten Ansatz eine zusätzliche, technikorientierte Rechtslogik auferlegt, die sich quer über alle bestehenden Rechtsgebiete legen würde.

Dies wäre undemokratisch, weil Rechtsprinzipien, die wie Trägerwände verschiedener Rechtsgebiete sektorale Kontextualisierung ermöglichen, durch EUVAS ins Wanken gebracht wĂĽrden. Eine solche querschnittliche Regulierung wĂĽrde zu zahlreichen WidersprĂĽchen und Kollisionen innerhalb unseres Rechtssystems fĂĽhren, wie es heute schon zum Teil durch das Datenschutzrecht geschieht. Eine schutzgut-entkoppelte Regulierung algorithmischer Datenverarbeitungen wĂĽrde wie Mehltau die mĂĽhsam erarbeiteten Schutzkonzeptionen anderer Rechtsgebiete ĂĽberlagern. Datenschutz ist Vorsorgerecht („Vorfeldschutz“). Mit EUVAS wĂĽrde neben den Datenschutz ein weiterer Vorfeldschutz etabliert. Die Regelungstechniken verschiedener Rechtsgebiete wĂĽrden durch einen weiteren präventiven Ansatz enorm verkompliziert, wenn nicht sogar ausgehebelt.

Dies würde zum Beispiel auch für den zivilrechtlichen Deliktsbereich gelten. Mit dem vorgeschlagenen risikobasierten Ansatz gehen Beweislastumkehrungen und letztlich die Abkehr vom auch im Deliktsrecht verankerten Grundsatz „in dubio pro reo“ einher.

Der risikobasierte Ansatz: Im Zweifel für den Kläger

Wir wĂĽrden ein Rechtssystem kreieren, in dem Menschen zunächst ihre guten Absichten nachweisen mĂĽssen, bevor sie mit Technologie agieren dĂĽrfen – und da reden wir nicht nur ĂĽber groĂźe Konzerne. Heute bearbeiten und nutzen viele Individuen komplexe Algorithmen. Ein präventiver Nachweis der Rechtschaffenheit ist die RĂĽckkehr zu der präkonstitutionalistischen Auffassung von hoheitlicher Gewalt aus dem Mittelalter. Vor dem Konstitutionalismus wurden Staaten als Sittenwächter legitimiert: der gute Staat konnte nur durch moralische BĂĽrger existieren. BĂĽrger hatten deswegen zunächst Pflichten und daraus ergaben sich ein paar Rechte. Dieser Legitimationsnarrativ wurde durch den Konstitutionalismus umgekehrt: Der Staat wurde dadurch legitimiert, dass dieser die Grundrechte ihrer BĂĽrger zu schĂĽtzen hatte. Im Zweifel waren Demokratien die politische Form, „die sogar bei einer Republik von Teufeln“ – so das Diktum Kants – funktioniere. Und eine der konstitutiven Säulen bestand daraus, dass BĂĽrger nicht nachweisen mussten, dass sie gute Absichten hatten.

Kategorienfehler. Grundrechte gibt es nur fĂĽr Menschen

In dem DEK-Bericht wird unterstellt, dass algorithmische Systeme und Daten allgemeinen rechtlichen Vorgaben unterworfen werden können. Das ist so, als würde man versuchen, Infrastruktur einerseits und kommerzielle Dienstleistungen andererseits mit denselben Bewertungskriterien zu erfassen. Das ist ein fundamentaler Kategorienfehler. Individuen können nicht fundamentalrechtlich geschützt werden, indem Informationen so behandelt werden, als wären sie Rechtssubjekte. Grundrechte gelten für Menschen. Sie sollten nicht für das gelten, was Menschen wissen können: staatliche Abwehrrechte gegen Wissen – das wäre die Schubumkehr der Grundrechte und zugleich ihr Ende als Fundament unserer Demokratie. Grundrechte erfassen alle Lebensdimensionen, und zwar in erster Linie als Abwehrrechte gegen staatliches Handeln. In ihrer zivilrechtlichen Dimension sind sie wegen ihrer gegenseitigen Konkurrenz noch komplexer und schwieriger zu fassen. Ob in einem Bus, in einem Schiff, auf der Straße oder online. Sie hängen nicht von Medium ab. Algorithmische Systeme sind extrem kontext- und anwendungsabhängig. Die sozialen Konflikte, die sie amplifizieren oder verursachen können, werden nicht durch Technik gelöst.

Aus der Vergangenheit lernen

Einst wurde erwartet, die Waschmaschine würde Frauen im Haushalt entlasten und dadurch zu mehr Frauen in der Arbeitswelt führen. Das lässt sich heute leugnen. Allerdings verbesserten sich mit der Waschmaschine die Sauberkeitsstandards im Haushalt. Mehr Frauen kamen deswegen aber nicht auf den Arbeitsmarkt. Denn die seinerzeitigen Gesetze und die damalige soziale Stellung der Frau in der Gesellschaft errichteten noch immer zu hohe Hürden für Frauen: ihre Ehemänner mussten eine nicht-häusliche Arbeit genehmigen. Da war auch die Waschmaschine machtlos. Frauen mussten am Arbeitsplatz soziale Vorurteile, sexuelle Belästigung u.v.m. aushalten. Technologie amplifiziert lediglich die soziopolitischen Regeln einer Gesellschaften. Eine Regulierung der Waschmaschine, um mehr Frauen auf den Arbeitsmarkt zu bekommen, hätte auch nicht weitergeholfen.

Leider verfällt die DEK genau in dieses Denkschema und will „Waschmaschinen“ regulieren, um Diskriminierung und andere negative Effekte zu regeln. Dieser Ansatz hilft nicht, er unterminiert sogar unser rechtsstaatliches, demokratisches System.

„Konzepte, an denen Zweifel bestehen, sollten nicht als Wahrheiten aufgezwungen werden“, sagte der Arzt und Humanist Miguel Servetus. Der DEK-Bericht bereitet einen wunderbaren Boden fĂĽr Diskussionen ĂĽber die Zukunft der Demokratie im digitalen Zeitalter; nicht als Empfehlungen, sondern lediglich als Diskussionsgrundlage sollte der DEK-Bericht verstanden werden.